Mô hình học sâu trên thiết bị biên: Triển khai các mô hình TensorFlow, PyTorch và ONNX trên Jetson

Bài viết này sẽ phân tích cách thức triển khai, lợi ích và ứng dụng của các mô hùng học sâu như TensorFlow, PyTorch và ONNX.

Ngày nay, trong xu thế phát triển mạnh mẽ của trí tuệ nhân tạo (AI) thì nhu cầu để thực hiên các mô hình học sâu trên các thiết bị biên (edge) cũng không ngừng tăng lên. Chính vì vậy, các thiết bị biên như NVIDIA Jetson đang trở thành một nền tảng lý tưởng để triển những ứng dụng AI nhờ vào khả năng xử lý dữ liệu tại chỗ và tiết kiệm băng thông trong quá trình kết nối. Bài viết này sẽ phân tích cách thức triển khai, lợi ích và ứng dụng của các mô hình học sâu như TensorFlow, PyTorch và ONNX.

Định nghĩa về mô hình học sâu trên thiết bị biên (edge) và tính toán biên

Mô hình học sâu được xem là một nhánh của AI, chúng thường sử dụng các mạng nơ-ron sâu để học và xử lý tập dữ liệu phức tạp. Các mô hình này được huấn luyện trên các máy chủ hoặc trung tâm dữ liệu với GPU mạnh mẽ và gửi các dữ liệu đó lên đám mây để xử lý trong quá trình triển khai vào thực tế. Và hiện nay việc tính toán biên (Edge Comuting) được xem là một lựa chọn lý tưởng của mô hình học sâu.

Tính toán biên được định nghĩa là việc xử lý dữ liệu tại chính nơi nó được tạo ra thay vì gửi chúng lên máy chủ từ xa. Với mô hình học sâu trên thiết bị biên, các mô hình AI được triển khai trực tiếp trên các thiết bị nhỏ gọn như NVIDIA Jetson. Do vậy, điều này mang lại nhiều lợi ích vượt trội như:

- Giảm độ trễ: Do dữ liệu được xử lý ngay tại thiết bị nên không cần phụ thuộc vào tốc độ kết nối mạng.

- Bảo mật dữ liệu: Do dữ liệu không cần truyền ra bên ngoài nên sẽ giảm được nguy cơ rò rỉ thông tin.

- Tiết kiệm băng thông: Do việc xử lý dữ liệu tại chỗ nên sẽ loại bỏ được việc truyền tải dữ liệu lớn lên đám mây.

NVIDIA Jetson: Nền tảng lý tưởng cho mô hình học sâu trên thiết bị biên

NVIDIA Jetson là một dòng sản phẩm cứng nhúng được tối ưu hóa cho AI và mô hình học sâu được phát triển bởi NVIDIA. Nó có khả năng hỗ trợ triển khai các mô hình học sâu từ TensorFlow, PyTorch và ONNX một cách dễ dàng nhờ tích hợp một GPU mạnh mẽ. Một số các module phổ biến của NVIDIA Jetson bao gồm:

- Jetson Nano: Đây là một máy tính nhỏ, mạnh mẽ cho các ứng dụng nhúng và AI IoT mang lại sức mạnh của AI hiện đại. Bắt đầu với JetPack SDK các thư viện được tăng tốc để học sâu, thị giác máy tính, đồ họa, đa phương tiện.

- Jetson Xavier NX: Module này cung cấp tới 21 TOPS để chạy khối lượng công việc AI hiện đại, tiêu thụ ít nhất 10W điện năng và có kích thước nhỏ gọn nhỏ hơn một chiếc thẻ tín dụng. Nó có thể chạy song song các mạng Neural hiện đại và xử lý dữ liệu từ nhiều cảm biến có độ phân giải cao, mở ra cánh cửa cho các thiết bị máy tính nhúng và thiết bị biên.

- Jetson AGX Orin: Đây là một loại máy tính AI mạnh nhất thế giới dành cho các máy tự động tiết kiệm năng lượng. Hiệu suất gấp 8 lần thế hệ trước, 275 TOPS cho Multiple Concurrent AI Inference Pipelines và hỗ trợ giao diện tốc độ cao cho nhiều cảm biến khiến nó trở thành giải pháp lý tưởng cho các ứng dụng từ sản xuất, logistics đến bán lẻ và chăm sóc sức khỏe.

Cách thức triển khai TensorFlow, Pytorch và ONNX trên NVIDIA Jetson

1. TensorFlow trên Jetson

TensorFlow là một mô hình học sâu phổ biến với khả năng xử lý các mô hình phức tạp và hỗ trợ đa nền tảng được phát triển bởi Google. Việc triển khai TensorFlow trên Jeston có thể được tóm tắt như sau:

- Cài đặt TensorFlow: NVIDIA sẽ cung cấp phiên bản TensorFlow đã được tối ưu hóa cho Jetson thông qua NVIDIA JetPack SDK. Điều này giúp tận dụng GPU của Jetson để tăng tốc độ suy luận.

- Tối ưu hóa mô hình: Sử dụng TensorRT để giảm kích thước mô hình và gia tăng hiệu suất.

- Ứng dụng thực tế: TensorFlow trên Jetson thường được sử dụng trong các ứng dụng như nhận diện khuôn mặt, phát hiện đối tượng và xử lý ngôn ngữ tự nhiên.

Một ví dụ trong hệ thống giám sát giao thông, TensorFlow có thể giúp Jetson nhận diện các phương tiện, biển báo và phân tích dữ liệu theo thời gian thực.

2. PyTorch trên Jetson

PyTorch là một mô hình học sâu có tính linh hoạt cao và sử dụng dễ dàng được phát triển bởi Meta. Việc triển khai PyTorch trên Jetson có thể được tóm tắt như sau:

- Cài đặt PyTorch: NVIDIA JetPack SDK hỗ trợ PyTorch và cho phép các nhà phát triển tận dụng GPU Jetson để chạy các mô hình PyTorch.

- Tối ưu hóa mô hình: PyTorch hỗ trợ chuyển đổi mô hình sang định dạng TorchScript hoặc ONNX để cải thiện hiệu suất khi triển khai trên Jetson.

- Ứng dụng thực tế: PyTorch trên Jetson thường được sử dụng cho các ứng dụng như phân loại và phân đoạn hình ảnh, nhận diện hành động...

Một ví dụ điển hình trong robot công nghiệp, PyTorch giúp Jetson nhận diện các vật thể trên dây chuyền sản xuất và điều khiển robot thao tác một cách chính xác.

3. ONNX trên Jetson

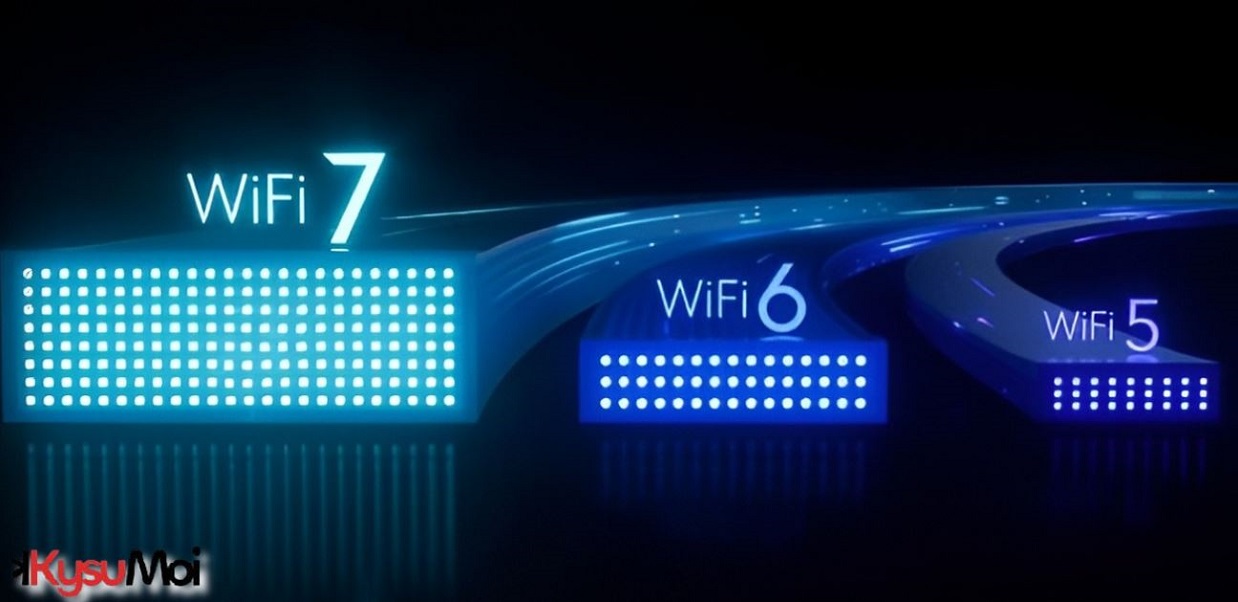

ONNX là một định dạng mở cho các mô hình học sâu có thể cho phép chuyển đổi giữa các mô hình khác nhau như TensorFlow và PyTorch. Cách thức triển khai ONNX trên Jetson:

- Tương thích đa nền tảng: ONNX cho phép chuyển đổi các mô hình từ TensorFlow hoặc PyTorch sang định dạng ONNX để triển khai trên Jetson.

- Tối ưu hóa với TensorRT: NVIDIA Jetson hỗ trợ TensorRT để tối ưu hóa các mô hình ONNX, giúp giảm độ trễ và tăng tốc độ suy luận.

- Ứng dụng thực tế: ONNX thường được sử dụng trong các hệ thống yêu cầu tích hợp nhiều framework hoặc triển khai nhanh trên thiết bị biên.

Một ví dụ trong các ứng dụng drone, ONNX có thể giúp Jetson phân tích video thời gian thực để nhận diện địa hình và lập kế hoạch bay.

Kết luận

Ngày nay, mô hình học sâu trên thiết bị biên được xem là sẽ mở ra một kỷ nguyên mới cho trong lĩnh vực AI do việc dữ liệu được xử lý ngay tại chỗ thay vì phụ thuộc vào đám mây. Khi đó, NVIDIA sẽ là một nền tảng lý tưởng để triển khai các mô hình học sâu trên thiết bị biên Jetson với khả năng hỗ trợ TensorFlow, PyTorch và ONNX. Bên cạnh đó, Jetson không chỉ giúp tăng tốc các ứng dụng trong lĩnh vực AI mà còn làm tiền đề thúc đẩy sự phát triển các ngành công nghiệp nhờ vào hiệu năng mạnh mẽ và hệ sinh phần mềm toàn diện của chúng.